Trí tuệ nhân tạo (AI) tạo sinh đang trở thành nguồn phát tán tin giả ngày càng đáng lo ngại. Nếu trước đây sự chú ý tập trung vào kết quả tìm kiếm văn bản và câu trả lời sai lệch, thì nay ảnh, video và âm thanh “deepfake” có thể bóp méo sự thật, làm tổn hại danh dự cá nhân, tác động tới những trụ cột quan trọng của xã hội.

Vì vậy, cần nhận diện những thách thức về mặt đạo đức và kỹ thuật trong việc phát hiện, ngăn chặn nội dung giả mạo, đồng thời thúc đẩy các giải pháp như minh bạch hóa, xây dựng hệ thống phát hiện và các biện pháp ngăn ngừa thông tin xấu độc, giả tưởng bởi AI.

Cơ chế lan truyền tin giả

AI đang phát triển quá nhanh khiến các biện pháp kiểm soát không theo kịp. Theo Viện Nghiên cứu Vận hành và Khoa học Quản lý (Mỹ), một báo cáo cho biết khoảng 57% nội dung trực tuyến hiện nay được tạo hoặc xử lý qua AI, phần lớn không được kiểm chứng, chủ yếu phục vụ mục tiêu “câu view”.

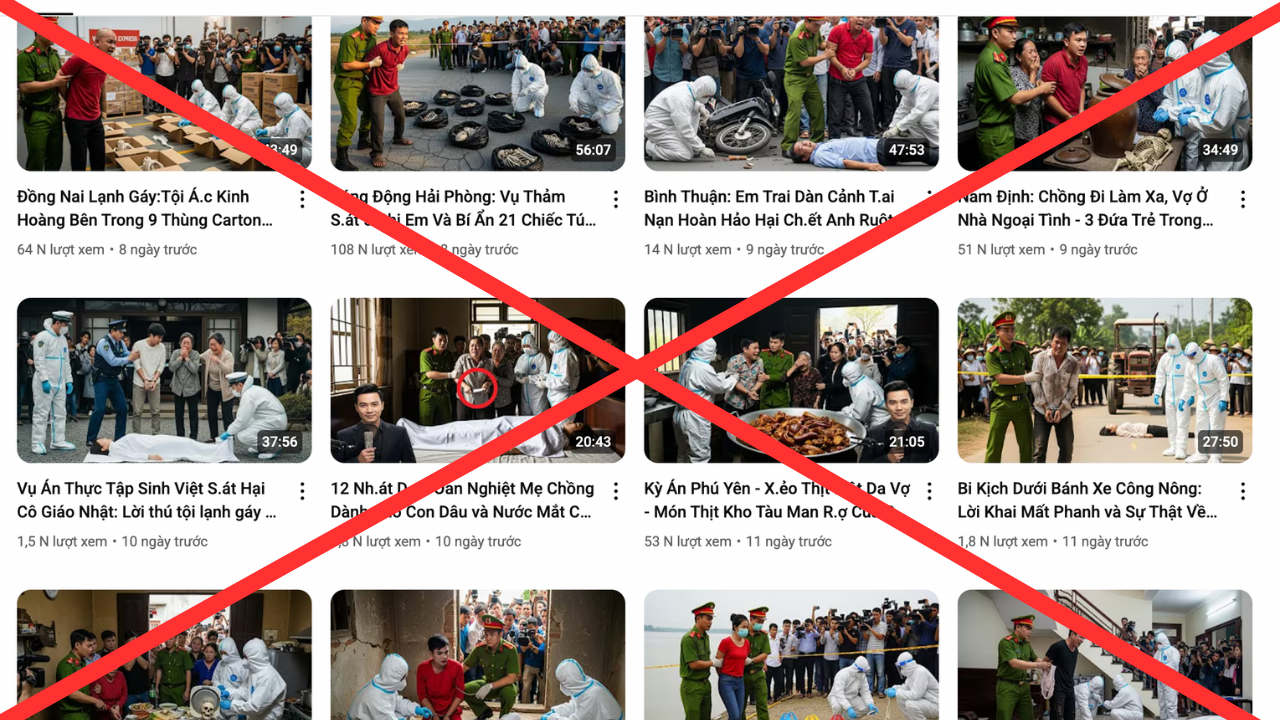

Những vụ án rùng rợn được xây dựng bằng AI, từ hình ảnh, âm thanh có nhiều lượt xem, gắn với các tỉnh thành tại Việt Nam kích thích sự tò mò.

Nhiều sự cố đã cho thấy rủi ro này, như việc Google buộc phải dừng công cụ Gemini đầu năm 2024 sau cáo buộc tạo ra hình ảnh sai lệch lịch sử. Một số công cụ khác bị chỉ trích phân biệt chủng tộc, gán hình ảnh, thông tin tiêu cực cho cộng đồng người da màu. Bài viết trên Bloomberg đã cảnh báo: “Con người vốn đã thiên vị. AI còn tệ hơn”.

Đáng lo ngại nhất là xu hướng tạo ra thông tin giả có chủ đích nhằm hãm hại cá nhân hoặc tổ chức, đặc biệt là deepfake.

Nghiên cứu cho thấy khi tiếp xúc với tin giả, con người có xu hướng chia sẻ lại, ngay cả khi biết đó là sai sự thật. Rõ nhất, gần đây hàng loạt video có nội dung rùng rợn về các vụ án được tạo bởi AI, gắn với câu chuyện về các tỉnh thành như Nghệ An, Thanh Hóa, Hải Phòng… đang tràn lan trên YouTube, nội dung bịa đặt, không kiểm soát, hút hàng triệu lượt xem.

Những video, nguồn tin này thường là về tin sốc dễ thu hút lượt thích và tương tác, vấn đề tài chính được cài cắm khéo léo, tin giả về chính trị để hạ bệ, cổ súy...

Cuộc chạy đua giữa công nghệ và tin giả

Metadata, siêu dữ liệu gắn với tệp hình ảnh số, có thể cung cấp những thông tin cơ bản như thời gian, địa điểm chụp ảnh. Nhiều công ty công nghệ hiện đã áp dụng kỹ thuật này để đánh dấu nội dung do AI tạo. Trước khi tìm ra giải pháp đáng tin cậy, việc xác minh sự thật vẫn phải dựa nhiều vào kiểm duyệt thủ công.

Ông Sam Gregory, Giám đốc điều hành tổ chức Witness, cho rằng trách nhiệm xử lý vấn nạn thông tin giả mạo do AI cần đặt lên vai những người thiết kế công cụ, xây dựng mô hình và phát hành chúng. Hiện quy định của các mạng xã hội về nội dung AI vẫn còn chưa chi tiết.

Sự phổ biến của các công cụ như ChatGPT, DALL-E, Midjourney đã khiến việc tạo hình ảnh, video, văn bản giả trở nên rẻ và dễ dàng hơn bao giờ hết, làm tràn ngập internet với nội dung khó phân biệt thật - giả.

Để hỗ trợ người dùng và nền tảng nhận biết nguồn gốc, Google, Adobe, Microsoft cùng nhiều công ty khác đang tìm giải pháp. Microsoft dự kiến bổ sung chức năng gắn watermark và metadata cho Designer và Image Creator, Adobe phát triển công cụ Content Credentials để theo dõi mọi chỉnh sửa bằng AI, Google gắn nhãn “do AI tạo” trên hình ảnh, hợp tác với Midjourney và Shutterstock.

Hình ảnh được tạo ra dễ dàng từ Midjourney.

Dù vậy, các giải pháp này vẫn ở giai đoạn đầu, trong khi tốc độ sản xuất nội dung AI tăng nhanh khiến khối lượng cần kiểm chứng vượt quá khả năng của con người. Europol dự báo đến năm 2026, tới 90% nội dung trên mạng có thể được tạo hoặc chỉnh sửa bởi AI. NewsGuard cũng ghi nhận số lượng website tin tức hoàn toàn do AI vận hành đã tăng gần gấp ba chỉ trong vài tuần.

Để thiết lập chuẩn chung, năm 2021, Microsoft, Adobe, BBC, Intel cùng nhiều tập đoàn thành lập Liên minh C2PA (Coalition for Content Provenance and Authenticity), xây dựng tiêu chuẩn mở cho phép xác thực nguồn gốc và lịch sử chỉnh sửa nội dung. Công nghệ này dùng mã hóa để bảo vệ quyền riêng tư và đã được tích hợp vào sản phẩm của Adobe, Microsoft. Tuy nhiên, việc áp dụng chuẩn C2PA hiện vẫn phụ thuộc vào từng công ty và cần nhiều bên tham gia hơn để trở thành quy chuẩn rộng rãi.

Ngoài metadata, các hãng cũng thử nghiệm watermark hiển thị trực tiếp, như DALL-E chèn dải màu cầu vồng vào ảnh, hoặc các công cụ phát hiện hậu kiểm. OpenAI từng ra mắt bộ kiểm tra văn bản AI, nhưng độ chính xác chỉ đạt 26%.

Các chuyên gia nhận định giải pháp công nghệ hiện tại chưa thể thay thế vai trò của con người. Một số nền tảng như Twitter đã thử nghiệm cơ chế kiểm chứng. TikTok yêu cầu gắn nhãn rõ ràng nếu nội dung AI mô tả cảnh thật, cấm sử dụng hình ảnh cá nhân chưa được phép. Meta và YouTube mới chỉ có quy định chung, chưa nêu rõ trường hợp được phép hay không.

TikTok gắn nhãn nội dung AI, nhằm mục đích giúp người xem phân biệt rõ ràng giữa nội dung thật và nội dung do AI tạo ra, đảm bảo sự minh bạch và ngăn chặn việc lạm dụng công nghệ AI.

Theo Meta, AI vượt khỏi khả năng quản lý của bất kỳ cá nhân, công ty hay quốc gia nào, đòi hỏi sự phối hợp của nhiều bên. Dù công cụ gắn nhãn AI mới chỉ ở giai đoạn thử nghiệm và vẫn có thể bị chỉnh sửa, đây là bước khởi đầu nhằm giảm thiểu rủi ro. Thực tế cho thấy nhiều người sẵn sàng tin vào thông tin họ muốn tin hơn là sự thật, nên hiệu quả của các nhãn này vẫn cần được nghiên cứu sâu hơn.

Giáo sư Joshua A. Tucker (ĐH New York) nhấn mạnh: “Chúng ta phải kiểm nghiệm để biết liệu các giải pháp này có thực sự thay đổi được nhận thức của người xem khi đối diện với nội dung AI gây hiểu lầm, và đâu là cách công bố thông tin hiệu quả nhất”.