NVIDIA mới đây đã giới thiệu "Chat with RTX", một chatbot AI được thiết kế để chạy offline trên PC Windows trang bị GPU NVIDIA RTX 30 hoặc 40 series. Lợi thế của công cụ này là cho phép người dùng cá nhân hóa chatbot với nội dung riêng. Dữ liệu nhạy cảm được lưu trữ trên thiết bị, tránh sử dụng dịch vụ đám mây tiềm ẩn rủi ro.

"Chat with RTX" hoạt động như một hệ thống cục bộ không cần truy cập Internet. Tất cả GPU GeForce RTX 30 và 40 có ít nhất 8 GB bộ nhớ video đều hỗ trợ ứng dụng này.

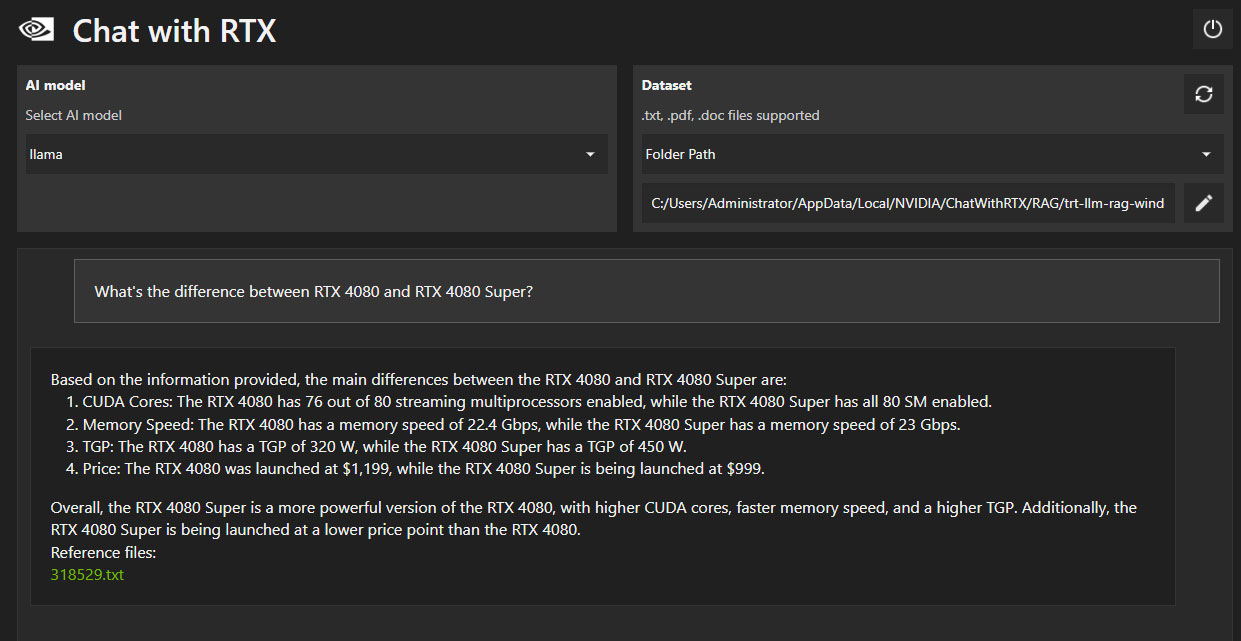

Chat with RTX hỗ trợ nhiều định dạng tệp, bao gồm văn bản, pdf, doc/docx và XML. Chỉ cần hướng ứng dụng đến thư mục chứa các tệp, chúng sẽ được tải vào thư viện trong vài giây. Ngoài ra, người dùng có thể cung cấp URL của danh sách phát YouTube và ứng dụng sẽ tải xuống bản ghi nội dung. Điều này cho phép người dùng truy vấn nội dung trong danh sách.

Dựa trên mô tả chính thức, người dùng có thể sử dụng Chat with RTX tương tự như ChatGPT bằng các truy vấn khác nhau. Tuy nhiên, kết quả được tạo ra hoàn toàn dựa trên tập dữ liệu cụ thể. Điều này phù hợp hơn cho các tác vụ như tạo tóm tắt và tìm kiếm nhanh trong tài liệu.

Sử dụng GPU RTX có hỗ trợ TensorRT-LLM cho phép người dùng làm việc với tất cả dữ liệu và dự án cục bộ. Do đó, không cần lưu trữ dữ liệu trên đám mây, tiết kiệm thời gian và mang lại kết quả chính xác hơn. NVIDIA cho biết TensorRT-LLM v0.6.0 sẽ cải thiện hiệu suất lên 5 lần và sẽ được ra mắt vào cuối tháng này. Phiên bản này cũng hỗ trợ các LLM khác như Mistral 7B và Nemotron 3 8B.

Tính năng chính của Chat with RTX:

Xử lý cục bộ: Chạy trực tiếp trên PC Windows RTX và máy trạm, mang đến phản hồi nhanh chóng và bảo mật dữ liệu người dùng.

Cá nhân hóa: Người dùng có thể tùy chỉnh chatbot bằng nội dung của họ, bao gồm tệp văn bản, PDF, DOC/DOCX, XML và video YouTube.

Tạo văn bản tăng cường truy vấn (Retrieval-Augmented Generation): Chatbot sử dụng RAG, phần mềm NVIDIA TensorRT-LLM và tăng tốc NVIDIA RTX để tạo nội dung và cung cấp câu trả lời phù hợp theo ngữ cảnh.

Ngôn ngữ mô hình lớn mã nguồn mở (LLM): Người dùng có thể chọn hai LLM mã nguồn mở, Mistral hoặc Llama 2, để huấn luyện chatbot của họ.

Thân thiện với nhà phát triển: Chat with RTX được xây dựng từ dự án tham khảo nhà phát triển TensorRT-LLM RAG, có sẵn trên GitHub, cho phép các nhà phát triển xây dựng ứng dụng dựa trên RAG của họ.

Yêu cầu và hạn chế:

Yêu cầu phần cứng: NVIDIA GeForce RTX 30 Series GPU trở lên với ít nhất 8GB VRAM, Windows 10 hoặc 11 và trình điều khiển GPU NVIDIA mới nhất.

Ứng dụng đang trong giai đoạn demo dành cho nhà phát triển, do đó khả năng nhớ ngữ cảnh còn hạn chế và xác định nguồn không chính xác.

Tải về Chat with RTX tại đây.