Mặc dù robot hiện nay đã đạt được những bước tiến trong giao tiếp bằng lời nói thông qua những phần mềm tiên tiến như ChatGPT, song khả năng thể hiện trạng thái cảm xúc trên khuôn mặt của chúng vẫn còn khá chậm chạp. Các nhà nghiên cứu của Đại học Columbia tin rằng robot Emo là một bước tiến đáng kể trong giao tiếp phi ngôn ngữ giữa con người và robot.

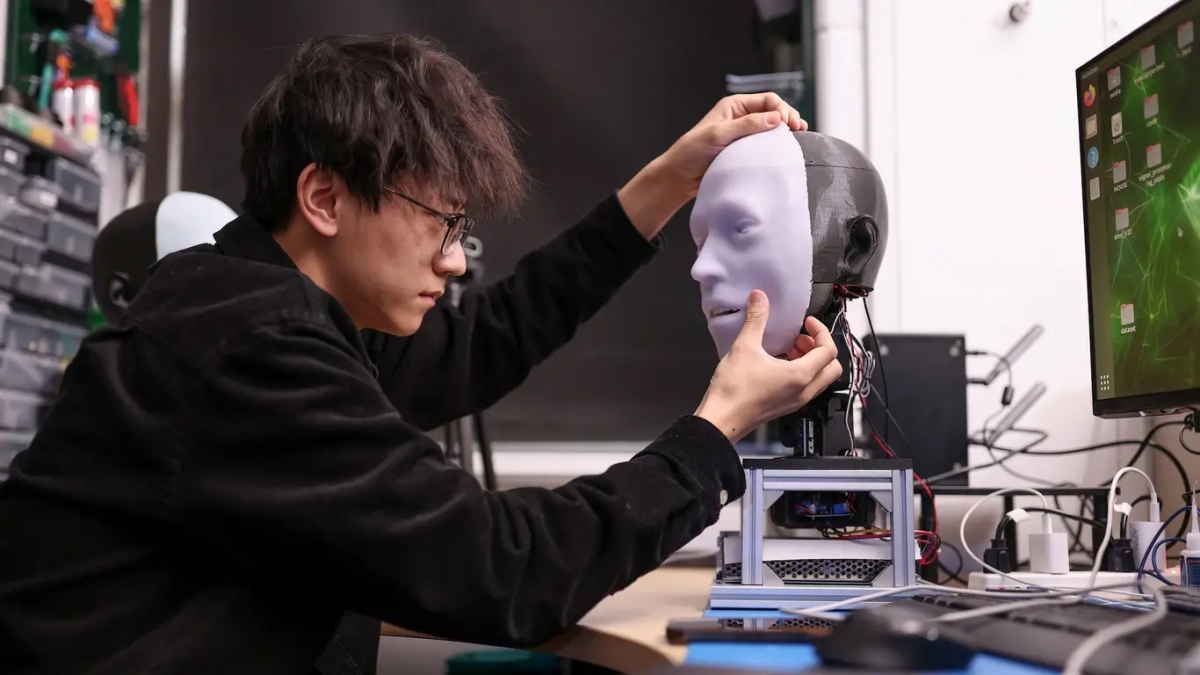

Các nhà nghiên cứu của Đại học Columbia tin rằng robot Emo là một bước tiến đáng kể trong giao tiếp phi ngôn ngữ giữa con người và robot. Ảnh: popsci

Robot Emo mới được công bố trên Tạp chí Science Robotics, có khả năng dự đoán các nét mặt của con người và bắt chước chúng cùng một lúc, thậm chí có thể dự đoán nụ cười sắp xuất hiện khoảng 0,84 giây trước khi nó xảy ra.

Ngoài ra, Emo có thể thể hiện 6 cảm xúc cơ bản như: Tức giận, ghê tởm, sợ hãi, vui vẻ, buồn bã và ngạc nhiên, cũng như một loạt các phản ứng nhiều sắc thái hơn. Điều đó là nhờ vào cơ nhân tạo làm từ dây cáp và động cơ. Emo thể hiện cảm xúc bằng cách kéo các cơ nhân tạo vào các điểm cụ thể trên khuôn mặt.

Tác giả chính của nghiên cứu cho biết các nhà khoa học đã phải đối mặt với những thách thức trong việc phát triển khuôn mặt biểu cảm một cách máy móc và xác định thời điểm tạo ra các biểu cảm tự nhiên, kịp thời.

Yuhang Hu - nghiên cứu sinh tiến sĩ và tác giả chính của nghiên cứu cho biết: "Mục tiêu chính của dự án Emo là phát triển khuôn mặt robot có thể nâng cao sự tương tác giữa con người và robot. Chúng tôi đặc biệt tập trung vào việc cải thiện một số kỹ năng đàm thoại - những kỹ năng rất quan trọng để khiến những hành động đó trở nên tự nhiên và hấp dẫn hơn. Khi robot ngày càng trở nên tiên tiến và phức tạp hơn, nhu cầu nâng cao tương tác trực quan cũng ngày càng tăng”.

Robot có hình dạng đầu người, sử dụng 26 bộ truyền động để thực hiện nhiều biểu cảm trên khuôn mặt và được bao phủ bởi da silicon. Ngoài ra, robot còn trang bị camera độ phân giải cao trong mắt để tương tác và giao tiếp bằng mắt giống như thật - rất quan trọng đối trong giao tiếp phi ngôn ngữ.

Nhóm nghiên cứu cũng đã sử dụng phần mền Trí tuệ nhân tạo (AI) để dự đoán nét mặt con người và tạo ra nét mặt robot tương ứng: “Emo giải quyết những vấn đề bằng cách sử dụng 26 động cơ, làn da mềm mại và đôi mắt được gắn camera. Vì vậy, nó có thể thực hiện các giao tiếp không lời, như giao tiếp bằng mắt và nét mặt. Emo được trang bị một số mô hình AI bao gồm phát hiện khuôn mặt người, điều khiển bộ truyền động khuôn mặt để bắt chước nét mặt và thậm chí dự đoán nét mặt con người. Điều này cho phép Emo tương tác theo cách cảm thấy kịp thời và chân thực”.

Robot được huấn luyện bằng quy trình gọi là "tự mô hình hóa", trong đó Emo thực hiện các chuyển động ngẫu nhiên trước máy ảnh, tìm hiểu mối tương quan giữa nét mặt và mệnh lệnh vận động. Sau khi quan sát các video về biểu cảm của con người, Emo có thể dự đoán nét mặt của mọi người bằng cách ghi nhận những thay đổi nhỏ khi họ dự định cười.

Nhóm nghiên cứu cho biết nghiên cứu này đánh dấu sự thay đổi trong tương tác giữa con người và robot (HRI), cho phép robot tính đến biểu hiện của con người trong quá trình tương tác, cải thiện chất lượng tương tác và thúc đẩy niềm tin.

Nhóm nghiên cứu dự định tích hợp giao tiếp bằng lời nói vào Emo, Yuhang Hu cho biết thêm: “Bước tiếp theo của chúng tôi liên quan đến việc tích hợp khả năng giao tiếp bằng lời nói. Điều này sẽ cho phép Emo tham gia vào các cuộc trò chuyện phức tạp và tự nhiên hơn”.